Nvidia's Nemotron 70B: Ein neuer Herausforderer für GPT-4o?

Nvidia hat mit dem Nemotron 70B Modell die AI-Community überrascht. Wir bei Evoya testen das Modell intensiv und stellen es bald unseren Kunden zur Verfügung.

Nvidia's Nemotron 70B: Ein neuer Herausforderer für GPT-4o?

Nvidia Nemotron 70B: Ein neuer Herausforderer für GPT-4o?

Gestern (16.10.24) hat Nvidia überraschend das Nemotron 70B Modell veröffentlicht und damit die AI-Community in Aufruhr versetzt. Ohne grosses Tamtam, aber mit umso mehr Substanz, hat Nvidia ein Modell mittlerer Grösse auf den Markt gebracht, das bereits jetzt für Furore sorgt. Die Veröffentlichung auf der Plattform Hugging Face hat schnell die Aufmerksamkeit auf sich gezogen, denn die ersten Eindrücke sind überaus vielversprechend. Nemotron 70B könnte der neue Stern am AI-Himmel sein, der mit “nur” 70 Milliarden Parametern in die Domänen wesentlich grösser Sprachmodelle vordringt.

Benchmark-König? Erste Eindrücke von Nemotron 70B

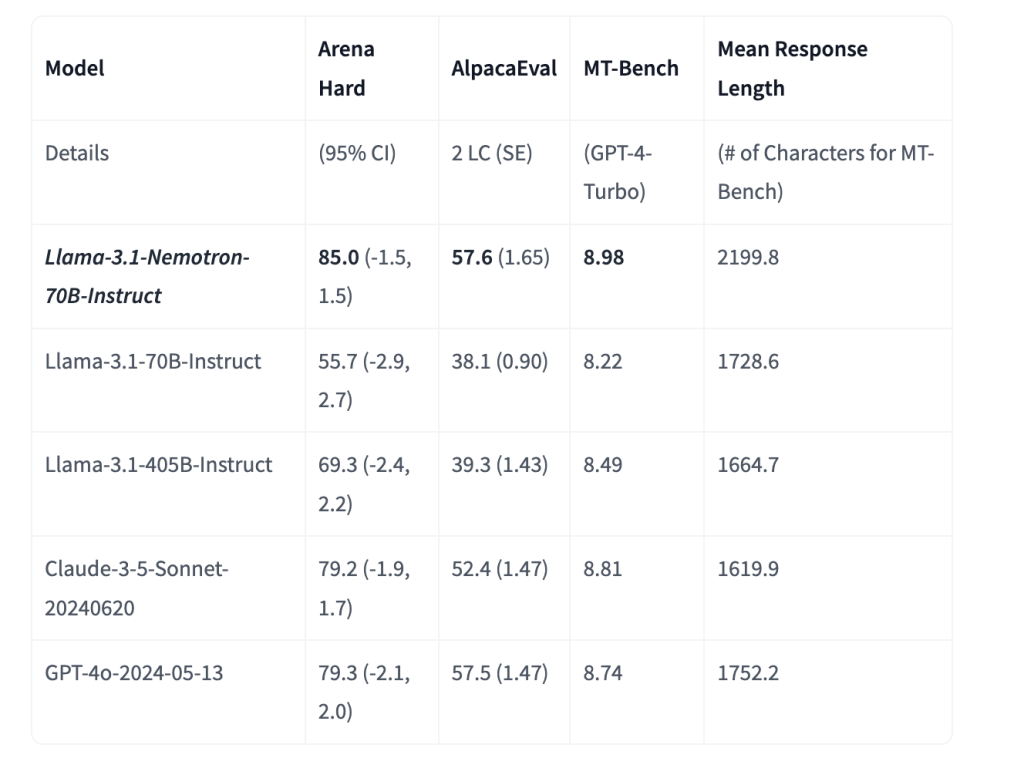

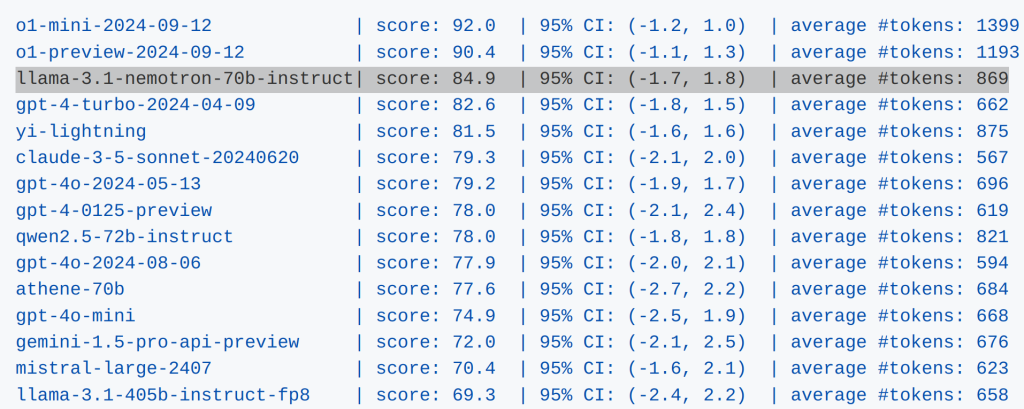

Die ersten Benchmark-Ergebnisse von Nemotron 70B sind beeindruckend und lassen aufhorchen.

Mit einem Score von 84.9 auf dem Arena Hard Benchmark übertrifft es die bisherigen Spitzenreiter wie OpenAI’s GPT-4o:

Interessanterweise schlägt Nemotron mit 70 Milliarden Parametern und basierend auf Llama 3.1 70B auch locker seinen grossen Onkel, das Llama 3.1 Modell mit 403 Milliarden Parametern.

Doch bevor wir voreilige Schlüsse ziehen, ist Vorsicht geboten: Diese Ergebnisse sind frisch und werden in den kommenden Tagen sicherlich noch genauer unter die Lupe genommen. An gewissen Stellen wird vermutet, dass hier ev. Benchmark Optimizing betrieben wurde. Die AI-Community wird gespannt beobachten, ob Nemotron 70B seine vielversprechenden Leistungen auch in der Praxis bestätigen kann.

Meta’s Llama 3: Die Basis für Nvidias Erfolg

Nvidia hat sich bei der Entwicklung von Nemotron 70B auf die bewährten Llama 3 Modelle von Meta gestützt. Diese offenen Modelle bieten eine solide Grundlage, die Nvidia mit fortschrittlichen Techniken wie Reinforcement Learning from Human Feedback (RLHF) weiter verfeinert hat. Diese Methode ermöglicht es dem Modell, aus menschlichen Präferenzen zu lernen und dadurch natürlichere und kontextuell passendere Antworten zu geben. Durch diese Verfeinerung hat Nvidia ein Modell geschaffen, das nicht nur leistungsstark, sondern auch anpassungsfähig ist.

Die Besonderheiten von Nemotron: Was steckt unter der Haube?

Mit 70 Milliarden Parametern ist Nemotron 70B vergleichsweise kompakt, was es für den Einsatz auf eigenen Servern prädestiniert. Die Open-Source-Natur des Modells ermöglicht es Entwicklern und Unternehmen, es nach ihren Bedürfnissen anzupassen und zu optimieren. Diese Flexibilität, gepaart mit der Möglichkeit, das Modell on-premise zu betreiben, macht Nemotron 70B zu einem potenziellen Gamechanger in der AI-Landschaft. Es bietet eine kosteneffiziente und leistungsstarke Alternative zu den grossen, proprietären Modellen.

Gamechanger-Potenzial: Was bedeutet das für die AI-Landschaft?

Die Möglichkeit, Nemotron 70B on-premise zu betreiben, könnte die Art und Weise, wie Unternehmen AI-Modelle einsetzen, verändern. Die Open-Source-Natur des Modells erlaubt es, massgeschneiderte Lösungen zu entwickeln, die spezifische Anforderungen erfüllen. Für viele Unternehmen ist on-premise KI eine Notwendigkeit, da sie die Kontrolle über ihre Daten behalten müssen – insbesondere in Bereichen wie Personendaten, welche gesetzlich streng reglementiert sind. Nemotron 70B bietet eine leistungsstarke und flexible Alternative zu den grossen, proprietären Modellen, die oft mit hohen Kosten und Einschränkungen verbunden sind.

Evoya’s Einsatz von Nemotron: Unsere Pläne und Erwartungen

Bei Evoya sind wir begeistert von den Möglichkeiten, die Nemotron 70B bietet. Mit seiner Kombination aus Leistungsfähigkeit, Flexibilität und Open-Source-Zugänglichkeit bietet es eine attraktive Alternative zu den etablierten, proprietären Modellen.

In der kommenden Tagen werden wir das Modell intensiv testen, um seine Leistungsfähigkeit und Anpassungsfähigkeit in realen Anwendungen zu evaluieren. Anschliessend wird Nemotron unseren Kunden in ihrem Evoya KI-Workspace zur Verfügung stehen. Wir sind überzeugt, dass Nemotron in verschiedenen Branchen, von der Kundenbetreuung bis hin zur Datenanalyse, wertvolle Dienste leisten wird.